Der wissenschaftliche Realismus basiert im Kern auf dieser Inferenz:

empirischer Erfolg à Wahrheit.

Natürlich werden unterschiedliche wissenschaftliche Realisten dieses Argument unterschiedlich ausbuchstabieren. Der Theorienrealist wird beispielsweise von dem Prognoseerfolg von wissenschaftlichen Theorien über einen Schluss auf die beste Erklärung auf die Wahrheit des wissenschaftlichen Theorienrealismus inferieren. Der Entitätenrealist kann hingegen von dem Manipulationserfolg mit theoretischen Entitäten über einen transzendentalen Schluss auf die Wahrheit des wissenschaftlichen Entitätenrealismus schließen. Aber jede Form von wissen-schaftlicher Realismus - so meine Behauptung - basiert auf der Inferenz oben.[1]

Philip Kitcher hat diese Inferenz noch etwas ausführlicher beschrieben:

(I) Eine wissenschaftliche

theoretische Annahme P spielt eine entscheidende Rolle in einer erfolgreichen systematischen Praxis; also ist P (ungefähr) wahr.

Das Idealisierungsargument besagt nun Folgendes: Viele wissenschaftliche theoretische

Annahmen sind Idealisierungen. Das heißt wir wissen, dass sie falsch sind. Sie spielen aber eine entscheidende Rolle in erfolgreichen

systematischen Praxen. Folglich ist die Inferenz von Erfolg auf Wahrheit nicht zuverlässig.

Das Idealisierungsargument erfährt in der Literatur meiner Meinung nach nach zu wenig Aufmerksamkeit. Es soll hier deshalb vorgestellt und diskutiert werden.

1. Das Idealisierungsargument

Es gibt zwei verschiedene Arten von Fiktionen in den Wissenschaften:

Abstraktion: Eigenschaften eines Systems werden im Modell des Systems ignoriert.

Idealisierung: Eigenschaften eines Systems werden im Modell des Systems hinzugedichtet oder missrepräsentiert.

Betrachten wir als erstes Beispiel die Umlaufbahn des Mondes um die Erde: Ein Modell dieser Umlaufbahn mag einfach die unterschiedlichen Elemente, aus denen die Himmelskörper bestehen, ignorieren. Das ist ein Fall von Abstraktion. Abstraktionen machen ein Modell unvollständig, aber nicht falsch. Ein Modell kann aber auch davon ausgehen, dass zwischen dem Mond und der Erde newtonsche Gravitation wirkt. Das ist dann eine Idealisierung und macht ein Modell falsch.

Offensichtlich sind Idealisierungen problematischer als Abstraktionen. Dieser Text handelt nur von Idealisierungen. Betrachten wir eine solche etwas genauer:

In idealen Gasmodellen wird angenommen, dass Gase aus sich zufällig bewegenden, dimensionslosen Teilchen besteht, die durch vollkommen elastische Stöße interagieren. Ihr Verhalten wird durch das ideale Gasgesetz beschrieben:

PV = nRT.

Das ideale Gasmodell ist - wie der Name schon sagt - eine Idealisierung. Aber diese Idealisierung ist nützlich, da das beobachtete Verhalten eines realen Gases unter vielen Bedingungen ungefähr dem entspricht, was wir beobachten würden, wenn es sich um ein ideales Gas handeln würde. Das ideale Gasgesetz wird auch heute in vielen Modellen erfolgreich verwendet, z.B. in Sternmodellen.

Betrachten wir also ein Modell, das erfolgreiche Vorhersagen macht. Es ist oft so, dass wir wissen, dass (a) das Modell Idealisierungen enthält und (b) diese Idealisierungen bei der Ableitung der erfolgreichen Vorhersagen eine Rolle spielen. Das Modell ist erfolgreich auch wegen seinen falschen Annahmen. Das ist ein Gegenbeispiel gegen die Erfolg-zu-Wahrheit Inferenz. Es gibt unzählige Idealisierungen in unseren reifsten und erfolgreichsten wissenschaftlichen Theorien und damit auch unzählige solche Gegenbeispiele. Dies stellt die Zuverlässigkeit der Erfolg-zu-Wahrheit-Inferenz in Frage. Denn eine Inferenz ist generell nur dann zuverlässig, wenn sie in hinreichend vielen Fällen bzw. mit einer hinreichend hohen Wahrscheinlichkeit zu einer wahren Konklusion führt.

Das Idealisierungs-Argument lautet also wie folgt:[2]

A1. Idealisierungen spielen eine entscheidende Rolle für den Erfolg unserer besten Modelle.

A2. Die Erfolg-zu-Wahrheit Inferenz betrifft auch Idealisierungen.

A3. Idealisierungen sind nicht wahr.

A4. Idealisierungen kommen zahlreich in erfolgreichen Modellen vor.

K1. Also: Die Erfolg-zu-Wahrheit Inferenz ist nicht zuverlässig. Damit bricht die zentrale Begründung für den wissenschaftlichen Realismus zusammen!

Der Schluss ist formal korrekt. Die Annahme A4 scheint mir faktisch evident. Dem Realisten bleibt also nur übrig, eine der ersten drei Annahmen abzuweisen.

2. Mögliche Einwände

Das heißt es gibt primär drei mögliche Einwände gegen dieses Argument:

A. Die Annahme A1 ist unwahr. Idealisierungen spielen keine entscheidende Rolle für den Erfolg unserer besten Modelle.

B. Die Annahme A2 ist unwahr. Die Erfolg-Wahrheit-Inferenz betrifft nicht auch Idealisierungen.

C. Die Annahme A3 ist unwahr. Idealisierungen sind wahr.

2.1. Idealisierungen sind nicht wesentlich

Der erste Einwand besagt, dass für den Erfolg der Wissenschaft Idealisierungen nicht wesentlich, sondern nur pragmatisch nützlich sind. Das ist eine prima facie plausible Behauptung. Wenn man sie begründen möchte, muss man Folgendes zeigen: Es ist im Prinzip möglich, die Idealisierungen aus unseren Modellen so zu eliminieren, dass sie danach noch gleich erfolgreich oder erfolgreicher sind. Wenn Idealisierungen auf diese Weise eliminierbar sind, spielen sie für den Erfolg keine entscheidende Rolle. Es gibt zwei Methoden, um genau dies zu zeigen.

2.1.1. Robustness Reasoning

Erstens können Idealisierungen mithilfe von "Robustness Reasoning" eliminiert werden.[3] Hier analysieren wir dasselbe System mit mehreren verschiedenen Modellen, die alle bestimmte nicht-idealisierte Kernannahmen teilen und sich nur in ihren idealisierten Annahmen unterscheiden. Wenn alle Modelle zu denselben empirischen Erfolgen führen, dann sind die idealisierten Annahmen offenbar nicht entscheidend für diese Erfolge. Entscheidend sind nur die idealisierten Annahmen. Also können wir vom Erfolg auf die Wahrheit dieser Kernannahmen schließen und die Erfolg-Wahrheit-Inferenz ist gerettet. Richard Levins drückt diese Idee so aus:

„Our truth is the intersection of independent lies.“

- Richard Levins: The Strategy of Model Building in Population Biology (1966). American Scientist 54(4), S. 421 - 431.

Betrachten wir ein vereinfachtes Beispiel: In Modellen der natürlichen Selektion in einer Population könnte ein Modell eine unendliche Population annehmen (also kein genetischer Drift). Das andere Modell könnte eine Population von 1.000.000 annehmen. Angenommen beide Modelle machen die gleichen (oder zumindest hinreichend ähnlichen) erfolgreiche Vorhersagen P. Dann kann man daraus schließen, dass der Erfolg nicht von den idealisierten Annahmen, sondern nur von der Kernannahme der natürlichen Selektion abhängt.

Die Kernannahme A ist robust gegenüber den idealisierten Annahmen X1,2,3; Y1,2,3 und Z1,2,3; insofern sie die Modelle M1, M2 und M3 stets zu der erfolgreichen Prognose P führt.

Es gibt jedoch einige Probleme mit der Methode des "Robustness-Reasoning":

Erstens ist nicht klar, wie dies dem wissenschaftlichen Realisten weiterhilft. Die Methode zeigt nur, dass eine bestimmte Idealisierung – sagen wir X1 – für den Erfolg eines Modells nicht notwendig ist. Sie zeigt aber nicht, dass einige Idealisierungen – sagen wir X1, X2 oder X3 – für den Erfolg eines Modells nicht notwendig sind. Die Erfolg-zu-Wahrheit-Inferenz bleibt immer noch bedroht.

Tatsächlich ist der Nachweis der Eliminierbarkeit bestimmter Idealisierungen trivial: Jede Behauptung kann im Prinzip aus einem Modell eliminiert werden, ohne ihr Erfolg zu verringern, vorausgesetzt, dass die richtigen Modifikationen an Hilfshypothesen vorgenommen werden (Duhem-Quine-These). Sowohl die idealisierten als auch die nicht-idealisierten Behauptungen können also prinzipiell eliminiert werden. Die Robustness-Reasoning Methode führt also dazu, dass wir gegenüber gar keinen Annahmen mehr wissenschaftliche Realisten sein können!

Zweitens besteht ein mehr praktisches Problem darin, dass Wissenschaftler sehr selten Modelle entwickeln, die robust gegenüber allen falschen Annahmen sind.

Jay Odenbaugh bringt dieses Beispiel:[4] Ökologen haben Muster in der Waldfolge gefunden - ähnliche Wälder werden ähnlichen sukzessiven Veränderungen folgen; unähnliche Wälder werden dazu neigen, auf ähnliche Zustände zusammenzulaufen. Waldsukzessionen werden als eine Art Markov-Kette modelliert. In einem von Henry Horn entwickelten Modell wird ein Wald als Bienenwabe unabhängiger Zellen behandelt. Jede Zelle enthält einen Baum und hat die Größe der Baumkrone. Es wird angenommen, dass alle Bäume gleichzeitig ersetzt werden und dass die Wahrscheinlichkeit, dass eine Art durch eine andere Art ersetzt wird, durch die Setzlinge im Unterholz der aktuellen Art bestimmt wird. Horn zählte in dem von ihn untersuchten Wald die Setzlinge in grauen Birkenzellen. Es gab 837 Setzlinge: 0 graue Birken; 142 rote Ahorne; 25 Buchen..

Mit diesem Modell können wir also Vorhersagen darüber treffen, wie sich ein Wald im Laufe der Zeit entwickeln wird. Und es passt ziemlich gut zu den Phänomenen. Aber: Dieses Modell enthält viele falsche Annahmen. Horn entwickelte andere Modelle, die andere Annahmen machten, beispielsweise Modelle, die den Bäumen unterschiedliche Lebensdauern geben. Diese Annahmen waren meistens auch falsch, weil wir die genaue Lebensdauer der Bäume nicht kennen. Aber der Punkt ist, dass es sich um je unterschiedliche falsche Annahmen handelt. Wir können also eine Art von Robustheitsanalyse durchführen und zeigen, dass die Annahme über die Lebensdauer des Baums für den Erfolg des Modells nicht wichtig ist.

Einer Vielzahl anderer falscher Annahmen wurde auf diese Weise jedoch nicht Rechnung getragen. So zum Beispiel die Art und Weise, wie die Wahrscheinlichkeiten berechnet werden, dass eine Baumart durch eine andere Baumart ersetzt wird. Diese Übergangswahrscheinlichkeiten sind sehr wichtige Aspekte des Modells, aber sie sind eindeutig idealisiert. Oder die Behandlung des Waldes als unabhängige Gruppe von Zellen oder das Ignorieren der Dichteabhängigkeit. All das wird in Horns verschiedenen Modellen nicht variiert.

Der Punkt ist dieser: Es ist in der wissenschaftlichen Praxis schwierig, diese Art von Robustheitsanalyse durchzuführen. Die meisten wissenschaftlichen Modelle haben so viele falsche Annahmen und das Konstruieren von empirisch äquivalenten Modellen und das Ableiten von Vorhersagen daraus ist keine leichte Aufgabe. Wissenschaftler haben im Allgemeinen schlichtweg keine Ressourcen, um für alle Annahmen eine Robustheitsanalyse durchzuführen. Die ursprüngliche Idee war aber einmal, dass man die idealisierten Annahmen aus einem Modell eliminiert und nur die nicht-idealisierten übrig bleiben. Wenn die Robustheits-analyse aber nicht durchführbar ist, wird man so nicht herausfinden, gegenüber welchen Annahmen man Realist sein soll und gegenüber welchen nicht.

2.1.2. De-Idealisierung

Ein zweiter Ansatz zur Eliminierung von Idealisierungen ist das einfache "De-Idealisieren" einzelner Modelle. Dieser Ansatz funktioniert am besten in Fällen, in denen Idealisierungen eingeführt werden, um Berechnungen zu vereinfachen.

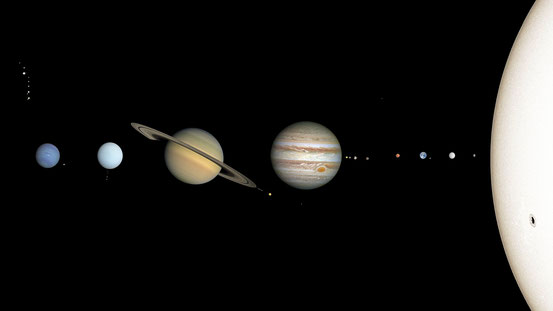

Beispiel: Angenommen, Wissenschaftler modellieren die Umlaufbahn des Jupiters um die Sonne und konstruieren die folgende Serie von Modellen:

M1: berücksichtigt nur den Jupiter und die Sonne, behandelt sie als Punktmassen und geht von der Newtonschen Mechanik aus.

M2: berücksichtigt den Jupiter, die Sonne und den Saturn, behandelt sie als Punktmassen und geht von der Newtonschen Mechanik aus.

M3: berücksichtigt den Jupiter, die Sonne und den Saturn, behandelt sie als Punktmassen und geht von der allgemeinen Relativitätstheorie aus.

Das Modell M2 enthält eine Idealisierung weniger als das Modell M1 und das Modell M3 enthält wiederum eine Idealisierung weniger als das Modell M2. Insofern stellen der Schritt von M1 auf M2 und der Schritt von M2 auf M3 eine De-Idealisierung dar. Die Strategie besteht nun in Folgendem: Man versucht zu zeigen, dass die De-Idealisierung eines Modells zu einem Anstieg von empirischem Erfolg führt. Wenn das gelingt, dann ist gezeigt, dass die Idealisierungen nicht wesentlich für den empirischen Erfolg des Modells sind. Die Umlaufbahn des Jupiters wird zum Beispiel wirklich häufig mit der Newtonschen Mechanik modelliert. Das hat aber nur einen pragmatischen Grund, da die Newtonsche Mechanik mathematisch einfacher zu handhaben ist als die Relativitätstheorie. Die Relativitätstheorie ist ganz klar empirisch erfolgreicher.

Aber auch diese Strategie hat ihre Probleme:

Erstens stößt sie, ebenso wie die Robustness-Reasoning-Methode, oft auf große praktische Schwierigkeiten. Häufig ist sie in der Praxis schlicht nicht durchführbar.

Zweitens ist es einfach nicht der Fall, dass eine De-Idealisierung ein Modell zwangsläufig erfolgreicher macht. Im Besonderen macht sie ein Modell häufig weniger allgemeinen und verringert damit seine Vereinheitlichungsleistungen.[5]

Beispiel: Wir können die Verhaltensweisen in Tierpopulationen erklären, indem wir uns auf evolutionär stabile Strategien berufen. Ein evolutionär stabile Strategie ist eine Strategie, die, wenn sie von allen Mitgliedern der Population übernommen wird, durch keine Alternativstrategie verbessert werden kann.

In Falke-Taube-Modellen wird zwischen Verhaltensweisen unterschieden. Falken kämpfen aggressiv um Ressourcen und hören nicht auf, bis sie verletzt sind oder ihr Gegner nachgibt. Tauben weichen sofort als Reaktion auf aggressives Verhalten zurück. Falke-Taube-Modelle zeigen, dass in einer Population, die nur aus Tauben besteht, ein Falke sehr gut abschneiden und mit großer Wahrscheinlichkeit überleben und sich fortpflanzen wird. In Folge wird die Anzahl an Falken an der Gesamtpopulation zunehmen. Daher ist eine Taube zu sein niemals eine ESS. Die Falke-Taube-Modelle sind sehr stark idealisiert.

Es wäre einfach sie zu de-idealisieren und die Details einer bestimmten Population zu berücksichtigen. Dann würde das Modell aber nur auf eine einzige Population zutreffen! Das heißt die De-Idealisierung eines Modells würde gerade zu einer Abnahme der empirischen Vereinheitlichungsleistungen führen.

Drittens kann man mit diesem Ansatz, selbst wenn er funktioniert, keine gehaltvolle Version des wissenschaftlichen Realismus begründen.[6] Angenommen wir können zeigen, dass ein Modell M2, das weniger idealisiert ist, erfolgreicher ist als ein stärker idealisiertes Modell M1. Dann können wir über die Erfolg-zu-Wahrheit Inferenz schließen, dass M2 näher an der Wahrheit ist als M1.

Das ist aber nur eine komparative These. M2 kann immer noch sehr weit von der Wahrheit entfernt sein. Die De-Idealisierungs-Strategie kann also nur einen sehr schwachen wissenschaftlichen Realismus begründen, nach der unsere derzeitigen Modelle relativ näher an der Wahrheit sind als ihre Vorgängermodelle. Sie kann aber nicht einen gehaltvollen wissenschaftlichen Realismus begründen, nach der unsere gegenwärtigen Modelle absolut nah an der Wahrheit sind.

2.2. Selektiver Realismus

Der zweite Einwand auf das Idealisierungsargument besagt, dass die Erfolgs-Wahrheits-Inferenz nur einige Annahmen in einem Modell betrifft. Die idealisierten Annahmen gehören nicht dazu. In Folge stellen sie die Zuverlässigkeit der konstitutiven Erfolg-zu-Wahrheit-Inferenz auch nicht in Frage.

Der Ansatz, dass die Erfolg-zu-Wahrheit-Inferenz nur einige Annahmen betrifft, ist in der Literatur auch als selektiver wissenschaftlicher Realismus bekannt. Es gibt drei dominante Formen eines selektiven wissenschaftlichen Realismus:

Epistemischer Struktureller Realismus: allein unser Glaube an den mathematisch-strukturellen Inhalt von erfolgreichen Modellen ist begründet.

Entitätenrealismus: allein unser Glaube an die von erfolgreichen Modellen postulierten theoretischen Entitäten ist begründet.

Einsatzrealismus: allein unser Glaube an die "working posits" von erfolgreichen Modellen ist begründet.

Diese drei Formen schließen aber nicht ausdrücklich idealisierte Annahmen aus. Der strukturelle Gehalt von erfolgreichen Modellen kann beispielsweise viele Idealisierungen enthalten. Die Idee hinter dem zweiten Einwand scheint also eine ganz neue Form des selektiven wissenschaftlichen Realismus zu sein:

Nicht-idealisierte Realismus: allein unser Glaube an die nicht-idealisierten Annahmen von erfolgreichen Modellen ist gerechtfertigt.

Dass Problem hierbei ist, dass der Schritt zu einem nicht-idealisierten Realismus bislang völlig ad hoc ist. Er zielt nur darauf ab, die Erfolg-zu-Wahrheit-Regel von Gegenbeispielen zu bewahren. Der nicht-idealisierte Realist muss erklären, warum idealisierte Annahmen unter Quarantäne gestellt werden sollen und inwiefern sie sich von nicht-idealisierten Annahmen wesentlich unterscheiden.

Vergleichen wir den nicht-idealisierten Realismus mit dem epistemischen Strukturenrealismus. Der epistemische Strukturenrealist besagt, dass nur der strukturelle Gehalt von Modellen einen radikalen Theorienwandel überlebt. Dadurch kann er erklären, weshalb er die Erfolg-zu-Wahrheit Inferenz nur auf den strukturellen Gehalt von Modellen anwendet. Und was noch viel wichtiger ist: Er kann im Prinzip einen Strukturenbegriff explizieren und dann den strukturellen Gehalt eines Modelles ausmachen. Er kann dann im der Praxis zeigen, an welche Teile eines wissenschaftlichen Modelles er glaubt und an welche nicht.

Der nicht-idealisierte Realist kann all das nicht. In der Theorie glaubt er nur an die nicht-idealisierten Annahmen von erfolgreichen Modellen. Das heißt aber nichts anderes, als dass er an die wahren Annahmen eines Modelles glaubt. Das ist aber einerseits völlig trivial. Andererseits weiß er im Einzelfall natürlich nicht, welche Annahmen eines Modelles wahr sind. D.h. er weiß im Einzelfall gar nicht, an welche Annahmen eines Modelles er glaubt. Der nicht-idealisierte Realismus ist insofern ein vollkommen trivialer und leerer wissenschaftlicher Realismus.

Mehr noch: Der zweite Einwand verfehlt die Pointe des Idealisierungsarguments.

2.3. Realismus über Idealisierungen

Der dritte Einwand besteht einfach darin zu sagen, dass idealisierte Annahmen doch wahr sind. Wir sollten die Erfolg-zu-Wahrheit Inferenz ernst nehmen und auf die Wahrheit von idealisierten Annahmen in erfolgreichen Modellen schließen. Also sind idealisierte Annahmen auch keine Gegenbeispiele gegen diese Inferenz.

Michael J. Shaffer behauptet, dass idealisierte Annahmen kontrafaktische Annahmen sind.[8] Sie sagen uns, wie die Welt ablaufen würde, wenn sie auf verschiedene Weisen anders beschaffen wäre. Sie beschreiben Systeme in anderen möglichen Welten. Das macht sie nicht nur wahr, sondern auch pragmatisch nützlich, weil idealisierte Annahmen es uns erlauben aktuale Systeme mit Systemen in anderen möglichen Welten zu vergleichen.

Es gibt mindestens zwei Probleme mit diesem Realismus über Idealisierungen:

2.3.1. Das ontologische Problem

Das erste Problem ist ein ontologisches Problem. Shaffers Behauptungen verpflichten uns auf einen lewisschen Realismus in Bezug auf mögliche Welten. Zum Beispiel verpflichtet sie uns auf die These, dass es eine mögliche Welt gibt, die genau so real ist wie unsere Welt und in der Sterne aus idealen bestehen.

Die meisten wissenschaftlichen Realisten werden einen solchen modalen Realismus aber abwegig finden. Es gibt neben dem modalen Realismus noch zwei weitere Wege, um zu erklären, wie kontrafaktische Annahmen wahr sein können:

(O1) Kontrafaktische Annahmen werden durch mögliche Welten wahr gemacht, aber mögliche Welten sind abstrakte statt konkrete Objekte.

(O2) Kontrafaktische Annahmen werden durch etwas anderes als mögliche Welten wahr gemacht. Diese Option verpflichtet uns nicht zu der Annahme, dass mögliche Welten (konkret oder abstrakt) real sind.

Beide Optionen haben meiner Meinung nach mit dem selben Problem zu kämpfen.

Stathis Psillos entscheidet sich für die Option O1.[9] Er behauptet, dass die idealisierten Annahmen in Modellen durch mögliche Welten wahr gemacht werden, mögliche Welten aber abstrakte Objekte sind. Die Erfolg-zu-Wahrheit Inferenz verpflichtet uns laut Psillos sowohl zu einem Realismus in Bezug auf konkrete Entitäten (Elektron) als auch auf abstrakte Entitäten (ideales Gas).

Das Problem ist, dass nicht zu sehen ist, wie man in dieser Option noch zwischen theoretischen konkreten Entitäten und abstrakten Entitäten unterscheiden kann. Eine Grundidee bei Psillos lautet, dass eine idealisierte Annahme über ideale Gase wahr sind, weil ideale Gase abstrakte Entitäten sind. Und sie sind erfolgreich, weil sich die Welt oft so verhält, als wären konkrete Gase ideale Gase.

Aber warum sollte man die selbe Argumentation nicht auch auf theoretische Entitäten verwenden? Eine Annahme über Elektronen ist wahr, weil Elektronen abstrakte Entitäten sind. Und sie ist erfolgreich, weil sich die Welt oft so verhält, wie es der Fall wäre, wenn Elektronen konkrete Entitäten wären. Ich sehe absolut nicht, wie man mit der Option O1 zwischen wahren Annahmen über abstrakte Entitäten und wahre Annahmen über konkrete Entitäten unterscheiden kann.

Das selbe Problem stellt sich für die Option O2. Der Gedanke bei Option O2 ist, dass

idealisierte Annahmen kontrafaktische Annahmen sind. Und kontrafaktische Annahmen können wahr sein, obwohl die durch sie beschriebenen Entitäten nicht existieren. Wie kann man in dieser Option

aber noch zwischen wahren Annahmen über ideale Gase und wahren Annahmen über Elektronen unterscheiden? Warum sollte man dann nicht sagen können, dass theoretische Annahmen über Elektron-en

wahr sind, obwohl die durch sie beschriebenen Entitäten nicht existieren?

2.3.2. Epistemologisches Problem

Das zweite Problem ist ein epistemologisches Problem. Es besteht darin, dass kontrafaktische Annahmen wohlmöglich gar nicht so nützlich sind. Das Problem lässt sich mit den Feinabstimmungsargumenten veranschaulichen. In diesen Argumenten werden oft auf kontrafaktische Annahmen getroffen. Wie etwa: Wenn die starke Kernkraft etwas größer wäre, gäbe es das Universum so nicht.

Aber wie können wir dann wissen, was in einer Welt passiert, in der die Naturgesetze anders

genug sind, um völlig elastische Stöße oder reibungsfreie Ebenen zuzulassen? Diese Welten wären ganz anders als die unsere. Ein ideales Gas könnte nicht aus den in unserer

aktualen Welt existierenden Molekülen bestehen und würde sich nicht nach den in unserer Welt geltenden Naturgesetze verhalten. Aber wie kann man dann den Erfolg von kontrafaktischen Annahmen, die

auf komplett andere Welten referieren, in unserer aktualen Welt erklären?

Banale kontrafaktische Konditionale sind von diesem Problem nicht betroffen:

(KK) Wenn der Ball die Vase getroffen hätte, wäre die Vase umgefallen.

Stellen wir uns eine mögliche Welt vor, die der unseren Welt weitgehend ähnlich ist. Der einzige Unterschied ist, dass der Ball die Vase getroffen hat. Das kontrafaktische Konditional ist wahr, wenn in dieser Welt die Vase umgefallen ist. Viele alltägliche modale Überzeugungen werden auf diese Art durch freie Rekombination gerechtfertigt: Wir stellen uns vor, dass Dinge in der tatsächlichen Welt neu angeordnet, dupliziert oder entfernt werden. Der Rest der Welt wird identisch zu unseren gedacht. Eine solche freie Rekombination ist nicht möglich, wenn wir uns zum Beispiel fragen, wie sich ein Stern verhalten würde, wenn er aus einem idealen Gas bestehen würde. Es ist daher auch fraglich, dass sich der Erfolg von idealisierten Annahmen in unserer Welt dadurch erklären lässt, dass sie auf Entitäten in anderen Welten referieren, die ganz anders sind.

3. Schlusswort

Die Debatte um das Idealisierungsargument spiegelt die Debatte um den ontologischen Status von mathematischen Entitäten wider. Eines der zentralen Argument für einen Realismus ist das Argument der Unentbehrlichkeit:

P1.

Wir sollten an die Existenz derjenigen Entitäten glauben, die für unsere besten wissenschaftlichen Modelle unverzichtbar sind.

P2. Mathematische Entitäten sind für unsere besten wissenschaftlichen Modelle unverzichtbar.

K1. Also: Wir sollten an die Existenz von mathematischen Entitäten glauben.

Ersetzen Sie einfach "mathematische Entitäten" durch "Idealisierungen" und wir haben das Problem, das zu Beginn dieses Textes skizziert wurde. Analog zu dem Idealisierungsargument gibt es bei diesem Argument drei mögliche Einwände:

A. Mathematische Entitäten spielen keine entscheidende Rolle für den Erfolg unserer besten Modelle, weil die Mathematik aus diesen Theorien eliminiert werden kann.[10]

B. Mathematische Entitäten spielen eine entscheide Rolle für den Erfolg unserer besten Modelle, aber die Erfolg-zu-Wahrheit Inferenz gilt nicht für sie.

C. Mathematische Entitäten sind (abstrakte oder konkrete) reale Entitäten.

Das übergreifende Problem bei beiden Argumenten scheint mir darin zu bestehen, dass wissenschaftliche Modelle sich einerseits auf Entitäten wie Gene, Elektronen und Schwarze Löcher beziehen, die der wissenschaftliche Realist anerkennen möchte. Andererseits beziehen sie sich aber auch auf Entitäten wie ideale Gase, reibungsfreie Ebenen, Zahlen und Mengen, deren Existenz manche wissenschaftliche Realisten nicht anerkennen möchten. Das Problem besteht dann in der Frage, ob, und wenn ja wie, man es rechtfertigen kann, die Erfolg-zu-Wahrheit Inferenz nur auf die "akzeptablen" Entitäten anzuwenden.

Einzelnachweise

[1] Siehe hierzu auch meinen Eintrag zu Seungbae Parks OMI-Argument.

[2] Psillos (2011) entwickelt ein ähnliches Argument.

[3] Odenbaugh (2011).

[4] ebd.

[5] Collin (2016).

[6] Siehe hierzu auch meinen Eintrag zur semantischen Inkommensurabilität.

[7] Worrall (1989).

[8] Shaffer (2012).

[9] Psillos (2011).

[10] Field (2016).

Literaturverzeichnis

Field, Hartry (2016). Science Without Numbers. Oxford: Oxford University Press.

Giere, Ronald G. (2006). Scientific Perspectivism. Chicago: University of Chicago Press.

Levins, Richard (1996).The Strategy of Model Building in Population Biology. American Scientist 54(4), S. 421 - 431.

Odenbaugh, Jay (2011). True Lies: Realism, Robustness, and Models. Philosophy of Science 78(5), S. 1177 - 1188.

Psillos, Stathis (2011). Living with the Abstract: Realism and Models. Synthese 180(1), S. 3 - 17.

Rice, Collin C. (2016). Factive Scientific Understanding Without Accurate Representation. Biology and Philosophy 31(1), S. 81 - 102.

Shaffer, Michael (2012). Counterfactuals and Scientific Realism. London and Basingstoke: Palgrave MacMillan.

Suárez, Mauricio (2010). Fictions, Inference, and Realism. In: John Woods (Hrsg.): Fictions and Models: New Essays. München: Philosophia Verlag, S. 225 - 246.

Vineberg, Susan (1996). Confirmation and the Indispensability of Mathematics to Science. Philosophy of Science 63, S. 256 - 263.

Weisberg, Michael (2007). Three Kinds of Idealization. Journal of Philosophy 104(12), S. 639 - 659.

Worrall, John (1989). Structural Realism: The Best of Both Worlds? Dialectica 43(1/2), S. 99 - 124.

zum vorherigen Blogeintrag zum nächsten Blogeintrag

Liste aller Blogbeiträge zum Thema "Wissenschaftlicher Realismus"

Philoclopedia

Philoclopedia

Kommentar schreiben