Chinesisches Zimmer

Das Chinesische Zimmer ist der Name für ein Gedankenexperiment des Philosophen John Searle.[1] Mit seiner Hilfe wird gegen die Thesen argumentiert, dass Computer allein dadurch Bedeutung, Bewusstsein, Intentionalität, u.Ä. erzeugen können, indem sie Zeichen manipulieren bzw. Programme ausführen.

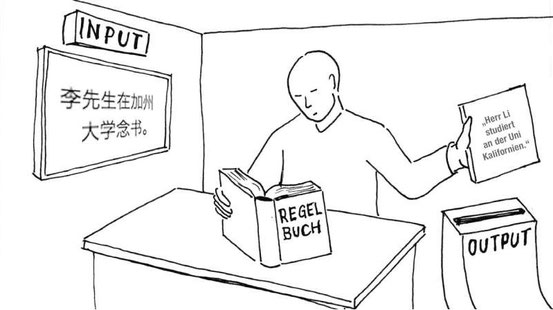

Das Gedankenexperiment geht so: Andrea ist im Besitz einer in ihrer Muttersprache verfassten Anleitung zur korrekten Beantwortung von Fragen in chinesischer Sprache. Sie steht in einem ansonsten leeren Zimmer vor einer Tür, unter der immer wieder Zettel durchgeschoben werden, auf denen Fragen in chinesischer Sprache stehen. Obwohl Andrea selbst kein Chinesisch spricht, kann sie die chinesische Fragen mit Hilfe der Anleitung korrekt beantworten. Personen außerhalb des Zimmers folgern aus den Ergebnissen, dass Andrea Chinesisch spricht, obwohl sie nur Zeichenreihen manipuliert, ohne diese zu verstehen.

Die Analogie zwischen Andrea und einem Computer soll nun u.a. zeigen:

1. Ein Computer kann ein Programm ausführen bzw. regelbasiert Zeichen-reihen manipulieren, ohne die Bedeutung der Zeichen zu verstehen. Die Fähigkeit, eine Syntax zu befolgen, ist also nicht hinreichend für Semantik. Dafür müsste der Computer Intentionalität aufweisen.

2. Ein Computer kann Fragen korrekt beantworten bzw. regelbasiert Zeichenreihen manipulieren, ohne über ein Bewusstsein zu verfügen. Das Bestehen des Turing-Tests ist also kein ausreichendes Kriterium für starke künstliche Intelligenz. Und der Computionalismus kann keine zufriedenstellende Theorie sein.

1. Historischer Hintergrund

1.1. Gottfried Wilhelm Leibniz

Das Chinesische Zimmer erinnert stark an Gottfried Willhelm Leibniz´ antimechanistisches Mühlenbeispiel:

„Man muß übrigens notwendig zugestehen, daß die

Perzeption und das, was von ihr abhängt, aus mechanischen Gründen, d. h. aus Figuren und Bewegungen, nicht erklärbar ist. Denkt man sich etwa eine Maschine, die so beschaffen wäre, daß sie

denken, empfinden und perzipieren könnte, so kann man sie sich derart proportional vergrößert vorstellen, daß man in sie wie in eine Mühle eintreten könnte. Dies vorausgesetzt, wird man bei der

Besichtigung ihres Inneren nichts weiter als einzelne Teile finden, die einander stoßen, niemals aber etwas, woraus eine Perzeption zu erklären wäre.“

- Gottfried Wilhelm Leibniz: Monadologie, § 17

1.2. Alan Turing

Alan Turing entwirft u.a. in "Intelligent Machinery" die Idee einer Papier-maschine, die ebenfalls den Grundgedanken von Searle vorwegnimmt. Eine Papiermaschine ist eine Art Softwareprogramm, das in natürlicher Sprache geschrieben ist und von Menschen ausgeführt wird, um Schach zu spielen. Der menschliche Bediener muss dabei gar kein Schach spielen können, er muss nur die einfachen Schritte ausführen, die die Papiermaschine ihm vorgibt. Er muss - genauso wie ein Schachcomputer - nicht einmal wissen, dass er gerade Schach spielt, die Anweisungen wie "N - QB7" müssen für ihn keine Bedeutung haben.

In "Computing Machinery and Intelligence" stellte Turing den sog. Turing Test vor: Ein menschlicher Fragesteller chattet mit zwei unbekannten Gesprächs-partnern, einem Menschen und einem Computer. Wenn der Fragesteller nicht ausmachen kann, welcher von beiden der Mensch ist, hat der Computer den Test bestanden, ihm wird eine dem Menschen ebenbürtige Intelligenz zugesprochen.

In den späten 1970ern behaupteten einige KI-Forscher, dass ihre Programme englische Sätze verstehen könnten. Einer dieser Forscher war Roger Schank.[2] Searles Gedankenexperiment war ursprünglich gegen die Behauptung von Schank präsentiert, dass sein KI-Programm die Sätze, auf das es antwortet, versteht.

1.3. Ned Block

Schließlich enthält ein Gedankenexperiment von Ned Block einige von Searles Kerngedanken. Ned Blocks Gedankenexperiment richtet sich gegen den Funktionalismus. Der Funktionalismus besagt, dass mentale Zustände letztendlich funktionale Zustände und somit vollumfänglich durch ihre kausale Rolle charakterisiert sind. Wenn der Funktionalismus wahr ist, dann sind mentale Eigenschaften unabhängig von ihrer ontologischen Realisierung und dann können auch Aliens oder Computer prinzipiell etwas verstehen, bezwecken oder erleben.

Doch wenn der Funktionalismus wahr ist, dann müssen auch andere Systeme Bewusstsein haben können, die dem menschlichen Gehirn noch viel weniger ähnlich sind als Computer oder Aliengehirne. Tim Maudlin hat beispielsweise ein System aus Wassereimern vorgeschlagen, dass den gleichen funktionalen Zustand wie ein menschliches Gehirn einnehmen kann.[3] Nach dem Funk-tionalismus müsste dieses System aus Eimern denken und verstehen können.

Blocks Gedankenexperiment schlägt nun in eine ähnliche Kerbe[4]: Angenommen die chinesische Regierung entscheidet sich für ein riesiges "Funktionalismus-Experiment" und gibt jedem chinesischen Bürger einen Anrufplan. Wenn das Handy eines Bürgers klingelt, steht auf dem Plan, welchen Mitbürger er jetzt wann anrufen muss. Der Anrufplan ist so aufgebaut, dass die Chinesen denselben funktionalen Zustand einnehmen, wie die Neuronen im Gehirn einer Person, die gerade Schmerzen empfindet. Gemäß der funktionalistischen Theorie müsste die chinesische Bevölkerung als Ganzes nun Schmerzen empfinden! Diese Schlussfolgerung scheint aber geradezu absurd. Wer sie ablehnt, muss aber auch verneinen, dass Computer Bewusstsein haben können. Denn Computer sind derzeit nichts weiter als Turing-Maschinen, die funktionale Zustände einnehmen.

2. John Searles Argument

1980 veröffentlichte John Searle den Aufsatz "Minds, Brains and Programs" in der Zeitschrift "The Behavioral and Brain Sciences". In diesem Aufsatz erläutert Searle das Gedankenexperiment vom Chinesisches Zimmer und baut darauf seine Argumentation auf. Er reagierte dabei auch ein halbes Dutzend Einwände, die ihm bei seiner früheren Präsentation des Argumentes entgegengebracht wurden. Darüber hinaus wurde der Artikel zusammen mit Kommentaren und Kritiken von 27 kognitionswissenschaftlichen Forschern veröffentlicht.

In den Jahrzehnten nach seiner Veröffentlichung war das Argument Gegenstand zahlreicher Diskussionen. Im Jahre 1984 unterbreitete Searle das Argument noch einmal in seinem Buch "Minds, Brains and Science". Und im Januar 1990 brachte es die populäre Zeitschrift Scientific American zu einem breiteren, öffentlichen Publikum. Im Aufsatz "Is the Brain's Mind a Computer Program?" nahm Searle das Argument noch einmal auf und folgte dabei dem von Paul und Patricia Churchland verfassten Artikel "Coud a Machine Think?". Bald darauf hatte Searle einen öffentlichen Austausch über das Argument mit Jerry Fodor.[5]

Das Herzstück des Argumentes ist die Situation eines Menschen, der rein syntaktisch einem vordiktierten Programm folgt, ähnlich wie Alan Turings Papiermaschine. Der Mensch, nennen wir sie Andrea, sitzt in einem leeren Raum und bekommt hin und wieder Zettel mit chinesischen Fragen durch den Türschlitz durchgeschoben. Andrea ist im Besitz einer Anleitung in ihrer Muttersprache zur korrekten Beantwortung der chinesischen Fragen. Wie ein Computer manipuliert sie einfach Zeichen bzw. "folgt" dem Programm, um die chinesischen Fragen zu beantworten, ohne sie jedoch zu verstehen. Für die Personen außerhalb des Zimmers hat es den Anschein, als ob Andrea Chinesisch verstehen müsste.

Ein Computer manipuliert ebenfalls nur Zeichen bzw. "folgt" einem Programm. Deshalb sollten wir auch bei ihm davon ausgehen, dass auch wenn er den Anschein erweckt und zum Beispiel den Turing Test besteht, er die Fragen de facto nicht verstehen kann.

Diese ursprüngliche Version des Argumentes zielt nur gegen die Möglichkeit von dem ab, was John Searle als "starke Künstliche Intelligenz" bezeichnet. Starke KI liegt nach Searle dann vor, wenn Computer die von ihnen manipulierten Zeichen verstehen und andere, menschenähnliche mentale Eigenschaften haben.

Wir können Searles ursprüngliches Argument nun formalisieren.

Dabei sei: L eine natürliche Sprache und P ein Programm, das die Zeichen in L so manipuliert, dass man sich mit P in L fließend unterhalten kann.

P1.

Wenn es prinzipiell eine starke KI geben kann, dann heißt das, dass es ein Computerprogramm P geben kann, dass die natürliche Sprache L verstehen kann.

P2. Ich kann prinzipiell all das tun, was ein Computerprogramm überhaupt nur mit L tun kann, nämlich formalen Regeln folgen, ohne L zu verstehen.

K1. Also: Es kann keine starke KI geben.

Die erste Prämisse entspricht dabei Searles Verständnis von starker KI. Die zweite Prämisse wird durch sein Gedankenexperiment des Chinesischen Zimmers gestützt. Und die Konklusion des ursprünglichen Argumentes besagt, dass es keine starke Künstliche Intelligenz geben kann, da sich Sprachverständnis nicht in Regelbefolgen erschöpfen kann.

4.1. Syntax und Semantik

In einer neueren Version des Argumentes argumentiert Searle, dass Computerprogramme nur auf Zeichenfolgen reagieren. Der menschliche Geist hingegen kann auch auf die Bedeutung von Zeichen reagieren. D.h. er kann diese Zeichen auch verstehen. Laut Searle ist das der entscheidende Punkt: "Syntax allein reicht für Semantik nicht aus und ist für diese auch nicht konstitutiv." Obwohl Computer also in der Lage sind, die Syntax einer Zeichenabfolge zu manipulieren, um angemessene Antworten zu geben, verstehen sie diese nicht. Denn sie können den Zeichen keine Bedeutungen zuordnen.

Das neuere Argument lässt sich nun wie folgt formulieren:[6]

P1. Programme arbeiten rein formal (syntaktisch).

P2. Der menschliche Geist hat mentale Inhalte (Semantik).

P3. Die Syntax ist für eine Semantik weder hinreichend noch notwendig.

K1. Daher sind Programme für den menschlichen Geist weder (a) hinreichend noch (b) notwendig.

Also 1: Wenn formale Programme nicht hinreichend für Geist und Bedeutung sind, können die derzeitigen Computer niemals semantische Inhalte verstehen.

Also 2: Wenn formale Programme nicht notwendig für Geist sind, dann sind der Funktionalismus allgemein und der Computationalismus im Speziellen falsch.

3. Kritik

Die Kritiken am ursprünglichen Argument von Searle folgen drei Hauptlinien:

a. Einige Kritiker akzeptieren die Prämissen inhaltlich, bestreiten aber formal, dass die Konklusion aus ihnen folgt. D.h. sie gestehen zwar ein, dass Andrea kein Chinesisch versteht. Allerdings sind sie der Meinung, dass daraus noch nicht folgt, dass überhaupt niemand in Searles Gedankenexperiment Chinesisch versteht. Siehe hierzu die Kritikpunkte 3.1. und 3.1.1.

b. Andere Kritiken akzeptieren die Konklusion, dass Computer, die nur Zeichen manipulieren, kein Verständnis aufbringen können. Sie sind jedoch der Ansicht, dass es auch Computersysteme geben kann, die mehr machen als nur Zeichen zu manipulieren. Siehe die Kritikpunkte 3.2. und 3.3.

c. Schließlich verneinen einige Kritiken die Wahrheit der Prämisse P2. D.h. sie sind der Meinung, dass Andrea entgegen Searles Meinung Chinesisch versteht. Siehe hierzu insbesondere die Kritikpunkte 3.4. und 3.5.

3.1. Systemkritik

Die Systemkritik räumt ein, dass P2. wahr ist bzw. Andrea kein Chinesisch versteht. Aber Andrea sei nur ein Teil, eine Zentraleinheit (CPU), eines größeren Systems, das wiederum Chinesisch versteht. Dieses größere System besteht aus einer riesigen Datenbank, den Arbeitsspeicher (Notizblöcke), den Anweisungen, usw. Kurzum: Das Gesamtsystem besteht aus all dem, was zur Beantwortung der Fragen notwendig ist - und es versteht Chinesisch.

Ned Block brachre die Systemkritik als erster hervor. Andere Vertreter sind u.a.

Jack Copeland, Daniel Dennett, Jerry Fodor, John Haugeland und Ray Kurzweil.

Searles Antwort auf die Systemkritik ist einfach: Im Prinzip kann Andrea das gesamte System internalisieren, das zur Beantwortung der Fragen notwendig ist. Sie kann alle Zettel auswendig lernen und dann alle Zeichen autonom manipulieren. Wenn sie aus dem Raum heraustritt und spazieren geht, kann sie sich vielleicht sogar auf Chinesisch unterhalten. Andrea würde jetzt das ganze System darstellen und trotzdem kein Wort Chinesisch verstehen!

3.1.1. Die Virtuelle-Geist-Kritik

In der Virtuelle-Geist-Kritik wird ebenso wie in der Systemkritik eingeräumt, dass Andrea kein Chinesisch versteht. Anders als bei der Systemkritik wird aber nicht davon ausgegangen, dass das Gesamtsystem Chinesisch versteht. Stattdessen soll es noch ein virtuelles System geben, dass sich ontologisch sowohl von Andrea (CPU) als auch vom Gesamtsystem unterscheidet. Dieses virtuelle System kann als virtueller Agent aufgefasst werden, der Chinesisch versteht. Bekannte Beispiele für solche "virtuelle Agenten" aus der Informatik sind Apple's Siri, Amazon's Alexa oder Microsoft's Cortana.

3.2. Roboter-Kritik

Die Roboterkritik räumt ein, dass K1. wahr ist bzw. dass Andrea und andere Systeme, die nichts weiter machen als Zeichen zu manipulieren, diese Zeichen nicht verstehen können. Aber ein Roboter, der nicht nur Zeichen manipuliert, sondern durch Sensoren auch mit der Umwelt interagieren kann, könne Chinesisch verstehen und mentale Zustände haben.

John Searle selbst führt als Beispiel an, dass Andrea bzw. ein Computer die Bedeutung des chinesischen Wortes für "Burger" nicht kennen würden. Es scheint vernünftig zu sein anzunehmen, dass wir aber wissen, was ein Burger ist, weil wir bereits Burger gesehen, gerochen und vielleicht auch gegessen haben. Von nun an konnten wir den deutschen Begriff "Burger" mit diesen Dingen, die wir gesehen, gerochen und gegessen haben, in Verbindung bringen und ihn somit verstehen. Die Idee ist nun, dass wenn wir einen Computer mit Sensoren wie Videokameras, Mikrofonen und Tastarmen ausstatten, er das tun könnte, was wir getan haben, als wir gelernt haben, den Begriff "Burger" zu verstehen.

Searles Antwort auf die Roboter-Kritik: Die Sensoren geben dem Computer auch nur weitere syntaktische Eingaben. Sie lassen ihn aber nicht verstehen.

3.3. Simulations-Kritik

Die Simulations-Kritik räumt ebenfalls ein, dass K1 wahr ist bzw. dass ein Programm, das denselben funktionalen Zustand wie Andrea einnimmt, die nur Zeichen manipuliert, diese Zeichen nicht verstehen kann. Ein Programm aber, das den weitaus komplexeren funktionalen Zustand eines Gehirns einnimmt, das Chinesisch versteht, würde Chinesisch verstehen können.

Searles Antwort auf die Simulations-Kritik: Angenommen, Andrea im chinesischen Raum befinde sich ein riesiges System aus Ventilen und Wasserleitungen, das genauso funktioniert wie die Neuronen in dem Gehirn eines chinesischen Muttersprachlers. Ein Programm bestimmt, welche Ventile als Reaktion auf die Eingaben geöffnet werden. Searle behauptet, dass ein derartiges System offensichtlich niemals Chinesisch verstehen könne und die Simulations-Kritik deshalb verfehlt sein muss.

3.4. Fremdpsychisches-Kritik

Die Fremdpsychisches-Kritik bestreitet die Wahrheit von P2. bzw. dass Andrea kein Chinesisch verstehen kann. Denn woher wissen wir, dass Chinesen Chinesisch verstehen? Offensichtlich durch ihren Umgang mit der chinesischen Sprache. Da Andrea bzw. digitale Sprachassistenten im Prinzip genauso mit der chinesischen Sprache umgehen können wie chinesische Muttersprachler, muss man ihnen ebenfalls ein Verständnis der Chinesischen Sprache zuschreiben.

Searles Antwort auf die Fremdpsychisches-Kritik: Das Gedankenexperiment fragt gerade nicht, wann ich weiß, dass andere Personen oder Computer Chinesisch sprechen. Es fragt vielmehr, was ich ihnen zuspreche, wenn ich sage, dass sie Chinesisch sprechen. Und im Kern besagt es eben, dass ich dabei mehr sage, als dass die Person oder der Computer Zeichen manipulieren kann.

3.5. Intuitions-Kritik

Die Intuitions-Kritik bestreitet ebenfalls die Wahrheit von P2. bzw. dass Andrea kein Chinesisch versteht. Denn woher wollen wir wissen, dass Andrea kein Chinesisch versteht, wenn sie die chinesischen Zeichen entsprechend manipulieren kann? Offensichtlich beruht Searles Argument auf einer Intuition.[7] Intuitionen aber können irreleiten und bilden daher keine starken Argumente.

Eine Antwort von Searle auf die Intuitions-Kritiken blieb m.W.n. bisher aus.

Siehe auch

Fußnoten

[1] John Searle: Minds, Brains, and Programs (1980)

[2] Robert Schank, Robert P. Abelson: Scripts, Plans, Goals, and Understanding: An Inquiry Into Human Knowledge Structures (1977)

[3] Tim Maudlin: Computation and Consciousness (1989)

[4] Ned Block: Troubles with Functionalism (1978)

[5] David M. Rosenthal: The Nature of Mind (1991)

[6] John Searle: Minds, Brains, and Programs (1980)

[7] Margaret Boden: Computer Models of the Mind (1988)

Stand: 2019

Philoclopedia

Philoclopedia

Philoclopedia (Montag, 05 August 2019 23:56)

https://pdfs.semanticscholar.org/cc3c/66c22c1d666129203b7aeb0e92a8fa85efec.pdf

Philoclopedia (Montag, 05 August 2019 23:55)

Das korrekte Verständnis des Phänomens der Intentionalität hat Auswirkungen auf die Grundlagentheorie der künstlichen Intelligenz (KI). Der Computerpionier Alan Turing formulierte 1950 den Turing-Test als Antwort auf die Frage, ob Maschinen denken können. Laut Turing kann ein Computer genau dann denken, wenn er in einem schriftlichen Gespräch (einem Chat) einen Menschen darüber täuschen kann, dass er kein Mensch ist. Laut Searle reicht dieser Turing-Test nicht aus, um einem Computer Gedanken zusprechen zu können. Ein solcher Computer würde sich laut Searle nur einem Menschen entsprechend verhalten, selbst jedoch nichts meinen oder denken. Für derartige mentale Prozesse ist laut Searle Intentionalität notwendig, die über das Verhalten hinausgeht. Um diese kritische Perspektive zu stützen, hat Searle ein Argument entwickelt, das die Verfehltheit des Turing-Tests beweisen soll. Dieses unter dem Namen chinesisches Zimmer bekanntgewordene Gedankenexperiment beginnt mit der Annahme einer Bibliothek. In dieser Bibliothek sitzt eine Person, die Zettel mit chinesischen Schriftzeichen gereicht bekommt. Die Person versteht kein Chinesisch. Allerdings stehen in den Büchern der Bibliothek Transformationsregeln: Die Person sucht in den Büchern nach der Zeichenfolge auf dem Zettel und schreibt die neue, im Buch angegebene Zeichenfolge auf einen neuen Zettel auf. Diesen gibt sie nun aus der Bibliothek heraus. Der Witz an dem Gedankenexperiment ist, dass in den Büchern zu den eingehenden chinesischen Sätzen passende, andere chinesische Sätze zugeordnet sind. Für einen chinesischen Beobachter außerhalb der Bibliothek entsteht so der Eindruck einer richtigen Kommunikation: Auf Zetteln, die in die Bibliothek gereicht werden, stehen korrekte chinesische Sätze, etwa Fragen. Auf den Zetteln, die aus der Bibliothek gereicht werden, stehen passende chinesische Sätze, etwa die Antworten auf die Fragen. Das chinesische Zimmer würde daher den Turing-Test bestehen.

Dennoch versteht niemand in der Bibliothek Chinesisch, weder die Person, noch die Bibliothek. Auch Bibliothek und Person zusammen verstehen Searle zufolge kein Chinesisch. Nach Searle zeigt dies, dass das Bestehen des Turing-Tests nicht ausreicht, um Sprache zu verstehen. Ein Computer mache im Prinzip nichts anderes als das chinesische Zimmer: Er transformiere Zeichenfolgen nach gegebenen, rein syntaktischen Regeln in neue Zeichenfolgen, ohne ihre Semantik zu verstehen. Doch wenn dies im Falle des chinesischen Zimmers nicht hinreichend für Gedanken sei, so sei auch nicht absehbar, wie jemals ein denkender Computer entstehen sollte.

Searle zieht aus seinem Gedankenexperiment die Konsequenz, dass zwischen einer schwachen und einer starken KI unterschieden werden müsse. Die schwache KI versucht menschliches Verhalten zu simulieren und Probleme zu lösen, die von Menschen nur mittels Intelligenz zu bewältigen sind. Ein solches Projekt ist nach Searle vollkommen legitim. Die starke KI möchte hingegen denkende Computer bauen. Vertreter der künstlichen Intelligenz haben auf dieses Argument, wenn überhaupt, verschieden reagiert. Manche Forscher beschränken sich auf die schwache KI. Andere weisen Searles Gedankenexperiment zurück. Manche erklären etwa, dass das chinesische Zimmer als Gesamtsystem tatsächlich Chinesisch verstehen würde. Gegenläufige Intuition beruhe darauf, dass man sich die Komplexität eines derartigen Systems nicht klarmachen.

Philoclopedia (Montag, 05 August 2019 23:52)

http://kwakuananse.de/http:/kwakuananse.de/archives/das-chinesische-zimmer/

Philoclopedia (Montag, 05 August 2019 23:51)

https://www.iep.utm.edu/chineser/

Philoclopedia (Montag, 05 August 2019 23:50)

https://www.youtube.com/watch?v=1MwGFG2hg3k

https://www.youtube.com/watch?v=pZx4U23oBDE

https://www.youtube.com/watch?v=9FNc9W8UzLo

https://www.youtube.com/watch?v=PCpgzy685W0

https://www.youtube.com/watch?v=pZx4U23oBDE

https://www.youtube.com/watch?v=q9LPmXaKo6Q

Philoclopedia (Montag, 05 August 2019 23:49)

https://de.wikipedia.org/wiki/Diskussion:Chinesisches_Zimmer