Philosophie der Quantenphysik

Die Philosophie der Quantenphysik (auch: Quantenphilosophie) interpretiert die ontologische und epistemologische Bedeutung des (1) mathematischen Formalismus und der (2) Beobachtungen, auf welchen die Quantenphysik,- d.h. die Quantenmechanik und die Quantenfeldtheorie,- aufgebaut sind.

Zwar gilt die Quantenphysik als eine der (1) mathematisch präzisesten und (2) empirisch am besten bestätigten naturwissenschaftlichen Theorien überhaupt. Aber aus (1) und (2) geht noch nicht eindeutig hervor, was für eine Wirklichkeit die Quantenphysik beschreibt. Ihre Deutungen sind deshalb in der Regel auch (derzeit) experimentell ununterscheidbar und deshalb Gegenstand der Metaphysik und Wissenschaftsphilosophie. Einige Wissenschaftlicher und insbesondere Positivisten halten sie aus diesem Grund für unwissenschaftlich.[1] Es hat sich aber herausgestellt, dass sich zentrale und originär-physikalische Begriffe der Quantentheorie (Messung, Beobachter, Wahrscheinlichkeit, Dekohärenz, usw.) ohne interpretativen Rahmen nicht definieren lassen. Andere Köpfe sehen die Formulierung einer konsistenten metaempirischen Interpretation deshalb als sinnvollen, wenn nicht sogar notwendigen Bestandteil der Quantenphysik an.[2]

Und eine PdQ steht auch nicht im luftleeren Raum, sondern muss klaren Bedingungen entsprechen, um wissenschaftlich ernstgenommen zu werden:

(a) Dem mathematischen Formalismus und den Experimenten der QP.

(b) Der Minimalinterpretation der QP, welche die Theorie testbar macht.

(c) Sie muss ergänzende Festlegungen treffen, die die PdQ individuiert.

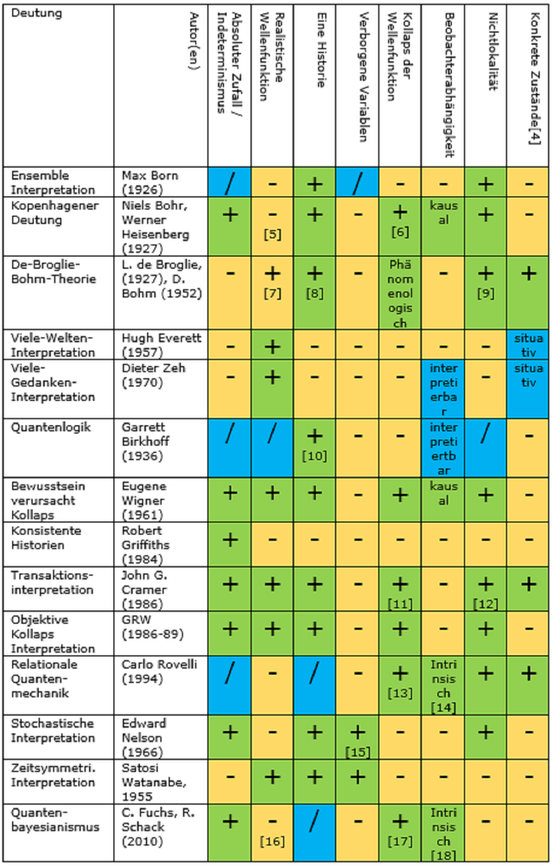

Die folgende Tabelle zeigt einen Vergleich der gängigsten Interpretationen[3]:

1. Philosophisch relevante Aspekte

"[…] Es ist sicher zu sagen, niemand versteht Quantenmechanik."

- Richard Feynman: The Character of Physical Law, Kapitel 6

Es gibt eine Reihe von Aspekten und Begriffen in der Quantenphysik, die nicht nur mit den etablierten Vorstellungen der klassischen Physik brechen, sondern auch der alltäglichen Anschauung zuwiderlaufen. Der Welle-Teilchen-Dualismus ist ein geradezu prädestiniertes Beispiel dafür. Diese Aspekte können zwar in Experimenten beobachtet und in Formeln berechnet werden, ihre tatsächliche Bedeutung versteht aber niemand. Das Doppelspaltexperiment etwa ist recht simpel, wie es aber im Detail abläuft, kann indes niemand erklären. Gleichzeitig scheinen gerade diese Aspekte philosophisch besonders interessant und deshalb intrepretationsrelevant zu sein.

1.1. Messzustand, Messgröße und Messwert

In der klassischen Mechanik lässt sich aus dem Ort und der Geschwindigkeit eines Körpers, bei Kenntnis der auf ihn einwirkenden Kräfte, dessen Bahnkurve vollständig vorausberechnen. Wenn also ein Laplacescher Dämon den Ort und die Geschwindigkeit jedes einzelnen makroskopischen Körpers im Universum und die in ihm wirkenden Naturgesetze kennen würde, dann könnte er prinzipiell die Zukunft vorausberechnen. Somit kann der Zustand eines makroskopischen Körpers eindeutig durch zwei beliebig genau messbare Größen (Ort und Geschwindigkeit) beschrieben werden. Zustand und Messwerte legen sich gegenseitig fest und müssen deshalb nicht separat behandelt werden.

In der Quantenmechanik sind der Ort und der Impuls eines Teilchens und damit auch dessen Bahnkurve nicht mehr beliebig genau vorhersagbar (Heisenbergsche Unschärferelation). Wenn also ein Streuexperiment an exakt zustandsgleichen Teilchen wiederholt wird, können diese trotzdem an unterschiedlichen Orten des Schirms auftreffen (Rutherford-Versuch). D.h. der Zustand eines Teilchens legt nicht die Messwerte fest, beide müssen separat behandelt werden.

Die messbaren Eigenschaften eines Teilchens bzw. die Messgrößen werden in der Quantenmechanik "Observablen" und die Messwerte "Eigenwerte" genannt. Ein Beispiel für eine Observable ist die abstrakte Eigenschaft "Ort" eines Teilchens und ein Eigenwert ist ein konkreter Messwert wie der "Ort x". Vor der Messung lassen sich den möglichen Eigenwerten der Observable "Ort" nur Wahrscheinlichkeiten zuordnen. Einige Eigenwerte folgen also nur möglich (indeterministisch), nicht notwendig (determinsitisch) aus den Teilchenzuständen.

Die klassische Mechanik[19] sowie die relativistische Mechanik[20] sind also deshalb deterministisch, da in ihnen jeder Systemzustand durch vorherige Zustände eindeutig festgelegt ist. Nichtlineare Systeme sind zwar nicht in diesem Sinne vorhersehbar, jedoch auch ontologisch vorherbestimmt (siehe: deterministisches Chaos). Jegliches anscheinend zufällige Verhalten und jegliche Wahrscheinlichkeit in einer makrophysikalischen Theorie resultieren allein aus theoretischer Unkenntnis oder experimenteller Unzulänglichkeit.

Die Kopenhagener Deutung der Quantenmechanik behauptet, dass die Quantenmechanik hingegen objektiv-indeterministisch ist.[21] Die Zukunft eines quantenmechanischen Systems sei also nicht nur epistemologisch unvorhersehbar, sondern auch ontologisch unvorherbestimmt. Die Tatsache, dass es beispielsweise unmöglich ist, den Zeitpunkt des Zerfalls eines einzelnen Radiumatoms vorherzusagen, ist demnach nicht darin begründet, dass der Beobachter nicht alle Informationen besitzt. Vielmehr gibt es tatsächlich keinen hinreichenden Grund für den konkreten Zeitpunkt des Zerfalls zu geben, der Zeitpunkt ist "objektiv zufällig".[22]

Es gibt aber auch einige Interpretationen, die die Quantenmechanik für deterministisch halten. Dazu zählen insb. die Viele-Welten-Interpretation und die De-Broglie-Bohm-Deutung. Laut der letzteren Interpretation bietet die Quantenmechanik keine vollständige Beschreibung der Natur, sondern lässt bestimmte Einflussfaktoren außer Betracht (verborgene Variablen). Wüssten wir um diese Einflussfaktoren, könnten wir auch den Zerfall eines einzelnen Radiumatoms vorausbestimmen. Die Frage nach der Determiniertheit oder Indeterminiertheit der Welt spielt in der Debatte um Willensfreiheit und somit auch in rechtsphilosophischen Straf- und politiphilosophischen Demokratietheorien eine herausragende Rolle (siehe: Libertarismus, Denkfehler).

1.2. Interferenz, Superposition und Welle-Teilchen-Dualismus

Eine weitere wesentliche Eigenschaft quantenmechanischer Zustände ist die Möglichkeit zur Interferenz. Ein Teilchen kann sich durch eine Überlagerung der möglichen Einzelzustände |p1⟩ und |p2⟩ in einem Gesamtzustand |Ψ⟩ befinden (Superposition). Dieser Gesamtzustand wird mathematisch durch eine Wellenfunktion dargestellt, die sich aus der Lösung der Schrödingergleichung ergibt, welche wiederum eine Form ähnlich einer Wellengleichung annehmen kann. Die Aufenthaltswahrscheinlichkeit eines Teilchens am Ort x ergibt sich nun aus dem Betragsquadrat der Wellenfunktion |Ψ(x)|². Im Zustand |Ψ⟩ ist die Aufenthaltswahrscheinlichkeit eines Teilchens daher nicht die Summe der möglichen Eigenwerte, wie man es aus der klassischen Mechanik erwarten würde. Vielmehr können sich Teilchen wie Wellen verhalten und interferieren.

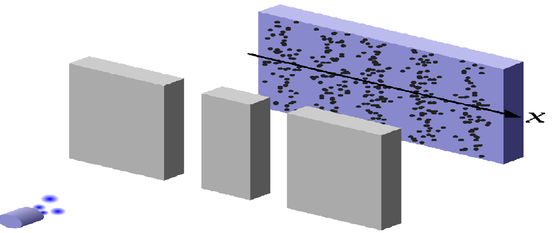

Das Doppelspaltexperiment zeigt sowohl diesen Interferenzeffekt als auch den statistischen Charakter der Quantenmechanik und ist somit ein gutes Beispiel für den Welle-Teilchen-Dualismus. Dabei werden Teilchen auf ein Hindernis mit zwei eng beieinanderliegenden Spalten geschossen und weiter hinten auf einem Schirm detektiert. Unter der Annahme des klassischen Teilchenmodells würde man auf dem Schirm zwei klar abgrenzbare Häufungen erwarten. Das tatsächliche Messergebnis sieht aber anders aus:

Koantum (CC BY-SA 3.0)

Das Messergebnis stimmt insoweit mit der Teilchenvorstellung überein, als dass jedes einzelne Teilchen auf dem Schirm genau einen Leuchtpunkt verursacht. Jedoch bilden die Leuchtpunkte keine klar abgrenzbaren Häufungen, sondern Interferenzstreifen, wie sie von klassischen Wellen bekannt sind. Diese punktierten Interferenzstreifen machen somit die die Teilchen- und Welleneigenschaften der Materie auf mikroskopischer Ebene sichtbar. Außerdem zeigen sie die statistische Wahrscheinlichkeitsverteilung der Ortsmesswerte. Wenn allerdings gemessen wird, welchen Weg ein Teilchen gewählt hat ("Welcher-Weg-Information"), benutzen auch alle anderen Teilchen diesen Weg und das Interferenzmuster wird zerstört.

Philosophisch stellt sich hier die Frage nach dem ontologischen Status quantenmechanischer Objekte: Ein Elektron ist sicher weder ein klassisches Teilchen noch eine Welle, aber was ist es dann? (Siehe: Quantenontologie) Und welchen Einfluss hat die Messung auf den ontologischen Status des Elektrons?

1.3. Messproblem, Messprozess und Wiederholungsmessung

Die Messung spielt also eine herausragende Rolle in der Quantenmechanik. Eine Messung an einem Teilchen bestimmt mit Sicherheit den Eigenwert der gemessenen Observable. Mathematisch befand sich das Teilchen vor der Messung aber in einer Überlagerung von Eigenzuständen zu verschiedenen Eigenwerten. Trotzdem wird bei der Messung kein verwaschenes Bild von verschiedenen Eigenwerten, sondern immer ein eindeutiger Wert gemessen. Direkt nach der Messung müsste eine Wiederholungsmessung nochmal dasselbe Ergebnis liefern, da jede Änderung der Eigenwerte Zeit braucht.

Das Messproblem besteht nun darin, dass der Teilchenzustand einerseits einer Überlagerung von Eigenwerten entsprechen soll, andererseits stets nur eindeutige Eigenwerte gemessen werden. Einerseits verläuft die zeitliche Entwicklung eines Teilchens - gemäß der Schrödingergleichung - strikt deterministisch und kontinuierlich, andererseits sind seine Eigenwerte nur statistisch vorhersagbar und werden beim Messprozess augenscheinlich diskontinuierlich festgelegt. Dieser Übergang vom Gesamtzustand in einen Eigenzustand wird auch als "Zustandsreduktion" oder "Kollaps der Wellenfunktion" bezeichnet. Laut den entsprechenden Kollaps-Theorien, zu welchen die Kopenhagener-Deutung zählt, erfolgt dieser Kollaps während dem Vorgang des Messens. Doch was genau zeichnet den Messprozess in Abgrenzung zu allen anderen physikalischen Prozessen aus? Warum befinden sich Teilchen und Messapparatur nach dem Messprozess nicht in einer gemeinsamen Superposition? Und stehen die Eigenwerte möglicherweise schon vor der Messung fest und werden vom derzeitigen Formalismus nur noch nicht erfasst? All dies sind Fragen, auf die es derzeit noch keine Antworten gibt.

Ein weiterer wichtiger Unterschied zwischen der klassischen und der quantenmechanischen Messung zeigt sich bei aufeinanderfolgenden Messungen von zwei verschiedenen Größen. Die klassische (ideale) Messung verändert das Messobjekt nicht, weshalb die Reihenfolge der Messungen unerheblich ist. Die quantenmechanische Messung verändert aber den Zustand eines Teilchens in Superposition durch eine Zustandsreduktion. Bei aufeinanderfolgenden Messungen von zwei Observablen ist die Reihenfolge daher nur unerheblich, wenn die Observablen einen gemeinsamen Eigenzustand haben. Einige komplementäre Observablen befinden sich aber niemals in einem gemeinsamen Eigenzustand, dass heißt ihre Eigenwerte können gar nicht gleichzeitig bestimmt werden. Bei diesen komplementären Observablen spielt die Reihenfolge der Messungen also immer eine Rolle. Wenn zum Beispiel der Impuls eines Teilchens genau bestimmt wird, dann ergibt sich die nachfolgende Ortsmessung aus einer unendlich breiten Wahrscheinlichkeitsverteilung. Wird aber zunächst der Ort bestimmt, dann ist danach der Impuls völlig unbestimmt.

Philosophisch stellt sich hier die Frage, ob sich ein Teilchen bis zur Messung tatsächlich in einer Superposition aus mehreren möglichen Gesamtzuständen befindet. Warum wir trotz dieser immer nur konkrete Eigenwerte messen. Und ob die Messung des Impulses tatsächlich den Aufenthaltsort "verschwimmen" lässt.

1.3. Nichtlokalität und Kausalität

Wenn zwei Teilchen miteinander wechselwirken, werden diese fortan durch einen einzigen Gesamtzustand beschrieben. Selbst wenn sich die Teilchen zuvor in klar definierten Eigenzuständen befunden haben, befinden sie sich nun in einer Überlagerung dieser Zustände. Es besteht jetzt eine Korrelation zwischen den Observablen der Teilchen. Daher bezeichnet man den Zustand der beiden Teilchen auch als "verschränkt". Wenn zwei Teilchen entsprechend präpariert werden und an einem Teilchen "Spin-up" gemessen wird, zerstört dass die Superposition und wir wissen aufgrund der Erhaltungssätze, dass das andere Teilchen den Eigenwert "Spin-down" hat.

Die Quantenverschränkung bleibt auch dann erhalten, wenn der Zeitpunkt der Wechselwirkung weit in der Vergangenheit oder die Teilchen weit voneinander entfernt liegen. Die Spinmessung an einem Teilchen legt den Spinwert des anderen Teilchens ohne Zeitverzögerung, also mit Überlicht-geschwindigkeit, fest, selbst dann wenn sich beide Teilchen an entgegengesetzten Enden im Universum befinden. Diese "spukhafte Fernwirkung" und ihre scheinbare Unverträglichkeit mit der Speziellen Relativitätstheorie waren eine der Gründe, weshalb Albert Einstein die Quantenmechanik ablehnte. Er betrachtete die Separierbarkeit und die Lokalität physikalischer Entitäten als fundamentale Prinzipen der Physik. Deshalb versuchte er zeitlebens nachzuweisen, dass die QM unvollständig ist und durch lokale Variablen zu einer lokalen und realistischen Theorie vervollständigt werden muss.[23]

Dafür entwarf er 1935 zusammen mit Boris Podolsky und Nathan Rosen das EPR-Gedankenexperiment. Dieses Experiment war in seiner ursprünglichen Form praktisch nicht durchführbar. John Stewart Bell gelang es 1964 jedoch, die zentralen Prämissen des EPR-Experiments in der experimentell überprüfbaren Form der Bellschen Ungleichung zu formulieren. Wenn Einstein Recht hat, dann muss das Experiment diese Ungleichung bestätigen. Alain Aspect realisiert 1982 das Experiment und zeigte, dass es die Bellsche Ungleichung verletzt und Einstein folglich falsch lag. Einsteins Theorie lokaler Variablen und der ihr zugrundeliegende lokale Realismus sind also falsifziert. Auch alle in Nachfolge an Bell gemachten Experimente deuten darauf hin, dass die QM nicht auf lokalen verborgenen Variablen beruht sondern vollständig ist.[24]

Diese Ergebnisse birgen ein ontologisches Dilemma, nach dem die QM mindestens eines der beiden Prinzipien Lokalität oder Realismus verletzen muss:

- Wenn die QM nicht-realistisch ist, dann sind Eigenwerte wie der Spin vor der Messung objektiv unbestimmt (Realismus ist unwahr).[25]

- Wenn die QM nicht-lokal ist, dann können sich verschränkte Teilchen nicht-räumlich beeinflussen (Prinzip der lokalen Wirkung ist falsch).[26]

Die EPR-Debatte ist also deshalb philosophisch so gehaltvoll, weil sie uralte Frage nach der Realität von Eigenschaften, dem Holismus des Weltganzen und Wesen der Kausalität berührt.

1.4. Dekohärenz und ununterscheidbare Teilchen

Warum aber sind Makroobjekte immer real und lokal, wenn sie doch aus Quantenobjekten bestehen? Der Grund hierfür sind winzige Wechselwirkungen der Systeme mit der Umgebung, die unmittelbar zu dem Kollaps der Wellenfunktionen und Dekohärenzeffekten führen. Dekohärenzeffekt sind bei großen Objekten besonders stark, weshalb wir nie Tische oder Personen in einer Superposition beobachten. Auch Schrödingers Katze befindet sich nicht wirklich in einer Superposition zwischen "tot" und "lebendig", da sich so große Objekte kaum von der Außenwelt abschirmen lassen und stetig z.B. mit Gasteilchen oder Strahlungen aus der Umgebung wechselwirken. Das Phänomen der Dehohärenz lässt sich unmittelbar aus dem Formalismus der Quantenmechanik ableiten und experimentell nachüberprüfen. Er ist daher kein unmittelbarer Aspekt der metaempirischen PdQ. Dennoch spielt es dort eine wesentliche Rolle, da sie die Diskrepanz zwischen den ontologischen Aussagen der Interpretationen der Quantenmechanik und der Alltagserfahrung erklären kann.

Auf der mikroskopischen Ebene kommen Superpositionen dahingegen regelmäßig vor. Da einige komplementäre Observablen durch ihre Messung andere Messgrößen unscharf machen, ist es prinzipiell unmöglich, den Eigenzustand eines Teilchens vollständig zu bestimmen. Nur aufgrund der nicht-komplementären Observablen (wie etwa Masse oder Ladung) ist es aber unmöglich, zwei gleichartige Teilchen voneinander zu unterscheiden. Man spricht dann auch von ununterscheidbaren Teilchen.

Wenn bei einem Vielteilchensystem aus ununterscheidbaren Teilchen die Zuordnung der Teilchen geändert wird, hat dies keinerlei Auswirkungen auf die experimentellen Ergebnisse. Dadurch unterscheiden sich ununterscheidbare Teilchen empirisch in keiner Eigenschaft und widersprechen dadurch dem Leibniz-Prinzip, wonach zwei ununterscheidbare Entitäten identisch sind. Sie widersprechen zudem auch der Bündelonotologie, nach der Entitäten Bündel von Eigenschaften sind. Zuletzt werfen ununterscheidbare Teilchen die Frage auf, inwiefern eine Quantenontologie und die Rede von "Teilchen" überhaupt einen Sinn machen, wenn Teilchen doch keine Individuen sind und nach Willard v. O. Quine berühmten Diktum gilt: "No entity without identity."

Einzelnachweise

[1] C. A. Fuchs, A. Peres: Quantum Theory needs no "Interpretation"

[2] E. Dennis, T. Norsen: Quantum Theory: Interpretation Cannot be avoided. arxiv:quant-ph/0408178

[3] Die in den Zellen der Tabelle gezeigten Werte sind nicht unumstritten, denn die genauen Bedeutungen einiger der beteiligten Konzepte sind unklar und stehen selbst im Mittelpunkt der Kontroverse eine Interpretation. Für eine andere Tabelle, die Interpretationen der Quantentheorie vergleicht, siehe: Lombardi, Olimpia,, Fortin, Sebastian, 1979-, Holik, Federico,, López, Cristian,: What is quantum information?, ISBN 9781107142114, OCLC 965759965.

[4] Eine sperrigere, indes präzisere Bezeichnung wäre "Kontrafaktische Bestimmtheit".

[5] Nach Bohr hat das Konzept eines physikalischen Zustands, der unabhängig von den Bedingungen seiner experimentellen Beobachtung ist, keine klar definierte Bedeutung. Nach Heisenberg stellt die Wellenfunktion eine Wahrscheinlichkeit dar, nicht aber eine objektive Realität in Raum und Zeit.

[6] Gemäß

der Kopenhagener Interpretation bricht die Wellenfunktion zusammen, wenn eine Messung durchgeführt wird. Vgl. Abschnitt "Realismus und Kollaps der Wellenfunktion".

[7] Beide Teilchen und Führungswellenfunktion sind real.

[8] Eindeutige Partikelhistorie, aber mehrere Wellenhistorien.

[9] Die Art von Nichtlokalität, die von der Theorie verlangt wird, um die Bell-Ungleichungen zu verletzen, ist schwächer als die in EPR angenommene. Insbesondere ist diese Art von Nicht-Lokalität kompatibel mit keinem Signalisierungstheorem und Lorentz-Invarianz!

[10] Die Quantenlogik ist in ihrer Anwendbarkeit aber begrenzter als kohärente Historien.

[11] Der Kollaps des Zustandsvektors wird als Abschluss der Transaktion zwischen Emitter und Absorber interpretiert.

[12] Die

transaktionale Interpretation ist explizit nicht-lokal.

[13] Jede physische Interaktion wird als ein Kollaps-Ereignis relativ zu den beteiligten Systemen behandelt, nicht nur makroskopische oder bewusste Beobachter.

[14] Der Zustand des Systems ist beobachtungsabhängig, d. H. der Zustand ist spezifisch für den Referenzrahmen des Beobachters.

[15] Die

Annahme der intrinsischen Periodizität ist ein Element der Nicht-Lokalität, die mit der Relativität konsistent ist, da die Periodizität kausal variiert.

[16] Eine Wellenfunktion kodiert lediglich die Erwartungen eines Agenten für zukünftige Erfahrungen. Es ist nicht mehr real als eine Wahrscheinlichkeitsverteilung ist in der Bajian

(Bajaan Wahrscheinlichkeit).

[17] Obwohl QBism diese Terminologie vermeiden würde. Eine Veränderung der Wellenfunktion, die ein Agent einem System als Ergebnis einer Erfahrung zuschreibt, stellt eine Veränderung

seiner Überzeugungen über weitere Erfahrungen dar, die sie möglicherweise haben.

[18] Beobachter oder, richtiger, Teilnehmer sind für den Formalismus genauso wichtig wie die Systeme, mit denen

sie interagieren.

[19] Der Standpunkt, dass die klassische Mechanik wirklich deterministisch ist und Ungenauigkeiten auf die Unfähigkeit des Experimentators zurückzuführen

sind, ist nicht vollkommen unumstritten. Entgegengesetzter Ansicht war beispielsweise Karl Popper. Karl Popper: Indeterminism, S. 117–133 und Karl Popper: Indeterminism in Quantum Physics and in Classical Physics II, S.

173–195.

[20] Eine Ausnahme bilden vielleicht die in der Allgemeinen Relativitätstheorie aufkommenden Singularitäten.

[21] Gerhard Schurz: Wahrscheinlichkeit, S. 56

[22] A. Zeilinger spricht beispielsweise von einem "objektivem Zufall". Werner Heisenberg den Begriff der "Potentia". Auch Poppers Propensitäten-Interpretation liegt ein ähnliches Konzept von Wahrscheinlichkeit zugrunde.

[23] EPR: Can quantum-mechanical description of physical reality be considered complete?, S. 777–780

[24] Alain Aspect: Experimental Tests of Realistic Local Theories via Bell’s Theorem, S. 460

[25] Es gibt auch Interpretationen zur Bellschen Ungleichung, in denen das Prinzip der Lokalität beibehalten und das der Realität aufgegeben wird.

Vergleich: S. Gröblacher et al.: An experimental test of non-local realism, S. 871

[26] Albert Einstein betrachtete dieses Prinzip als eine notwendige Voraussetzung für die Existenz empirisch überprüfbarer Naturgesetze. Vergleich: Albert Einstein: Quantenmechanik und Wirklichkeit, S. 320–324.

Siehe auch

Stand: 2018

Philoclopedia

Philoclopedia

Philoclopedia (Freitag, 04 Oktober 2019 02:11)

https://www.youtube.com/watch?v=8fxRTtOQI60